KI-gestützte Anwendungen wie DeepL, ChatGPT oder perplexity.ai helfen beim Übersetzen, Programmieren, und Schreiben von Anträgen, Publikationen, Recherchen oder sogar „persönlichen“ Briefen. Ganz zu schweigen von den großartigen Werkzeugen, die im Datendschungel Muster erkennen können und die Forschung voranbringen. Aber welche Aufgaben wollen wir an die KI abgeben und was sollten wir selbst tun? Haben wir noch eine Wahl? Auf der Medientagung der Friedrich-Ebert-Stiftung im November 2023 hat Antonia Rötger, Wissenschaftsredakteurin am HZB, Fragen gesammelt. Die meisten bleiben erstmal offen.

Kann man mit ChatGPT gute Texte erzeugen?

Ja, aber nur, wenn man sich etwas Mühe gibt. Denn ChatGPT ist ein „stochastischer Papagei“ und ein „Wiederkäuer“. Durch Neukombination alter Formulierungen entsteht nicht wirklich etwas Neues. Auf die Schnelle erhält man Ergebnisse voller abgestandener Redensarten und Klischees. Mit sorgfältigem Prompten wird das besser. Karin Bjerregard Schlüter, Digitalexpertin und Professorin an der Universität der Künste Berlin, meinte auf der Medientagung, dass die Texte von ChatGPT in Richtung Mittelmaß tendieren. Das ist auch mein Eindruck: ChatGPT-Texte werden besser, wenn man sie strafft und versucht, das Wesentliche herauszustellen. Also doch nochmal Handarbeit am Text.

Wer ist für das Ergebnis verantwortlich?

Das ist die Person, die den Text mit Hilfe der KI erzeugt hat. Leider hat diese Person keine Ahnung, wie das KI-System aus den vorhandenen Daten die passenden Infobröckchen aussucht und miteinander kombiniert. Der entstandene Text klingt überzeugend, selbst wenn etwas Entscheidendes fehlt oder völlig falsch ist. Denn wenn ChatGPT keine Antwort finden kann, erscheint trotzdem ein Text: Das System spinnt sich dann einfach eine Antwort zusammen, es halluziniert und erfindet zum Beispiel Studien, die es nicht gibt. Man muss also jede Aussage überprüfen und die Quellen suchen. Alternativ könnte man mit perplexity.ai arbeiten, einem KI-System, das Herkunft und Kontext der Informationen angibt.

Wer soll den massenhaft produzierten „Content“ eigentlich lesen?

Aufmerksamkeit ist die knappe Ressource, um die immer mehr Inhalte konkurrieren. Das ist schon lange so. Die KI-Anwendungen ermöglichen nun erstens, in noch kürzerer Zeit noch mehr Content zu produzieren und zweitens, diese Inhalte noch viel stärker auf persönliche Interessen der Konsumenten zuzuschneiden. Beides ist nicht unbedingt ein Gewinn: Wir brauchen vertrauenswürdige Nachrichten, aber nicht unbedingt mehr davon, weil unsere Aufmerksamkeit und auch unsere Empathie so begrenzt sind. Das zweite Problem ist vielleicht noch gravierender: Je stärker aber Inhalte auf individuelle Interessen zugeschnitten werden, desto kleiner wird die gemeinsame Wissensbasis. Das sprichwörtliche „Lagerfeuer“, das vielleicht früher mal die Tagesschau war, gibt es nicht mehr. Wer im Katzencontent ertrinkt, bekommt von der Klimakrise nichts mehr mit und wird keine Notwendigkeit sehen, zu handeln. Das ist schwierig in einer Demokratie.

Wer entscheidet, was wir zu welchen Bedingungen nutzen können?

Nur wenige große Firmen, darunter Alphabet (Google), Microsoft und Meta (Facebook), haben in große „KI-Anwendungen für die Allgemeinheit“ investiert und treiben die Entwicklung voran. Regulierungen kommen spät, sind nicht immer ganz durchdacht oder werden von der Entwicklung überholt. Gemeinnützige Plattformen schaffen es bisher nicht, eine echte Konkurrenz zu werden. Das ist wirklich ein Problem.

Zehn Minuten ChatGPT – Wieviel Energie verbraucht das ungefähr?

Der eigene Rechner zieht in einer Stunde etwa 0,15 kWh. Aber damit ChatGPT läuft, stehen irgendwo riesige Server-Hallen, die Strom fressen. Auch das Trainieren der generativen Sprachmodelle benötigt enorm viel Energie und Ressourcen. Mit Hilfe von perplexity.ai habe ich ein paar Abschätzungen gefunden. So schätzt der Computerwissenschaftler Sajjad Moazeni (University Washington) auf Nachfrage der Internetplattform Yahoo Finance, dass eine E-Mail von ChatGPT etwa 10 bis 100mal mehr Energie benötigt als eine, die ein Mensch geschrieben hat ( Quelle Yahoo Finance vom 30.09.2023).

Geben wir nur langweilige Arbeit ab oder wird – im Gegenteil – unsere Arbeit langweiliger?

Ein Szenario für meine Arbeit in der Wissenschaftskommunikation: künftig gilt es als Zeitverschwendung, mit den Forschenden zu sprechen, um danach über ihre Arbeit zu berichten. Ich gebe nur noch das Paper ein und ein paar Stichworte (Text für Laien, Schwerpunkt Energiewende) und schon spuckt mir die Maschine Texte in beliebiger Form und Länge aus, komplett mit netten Illustrationen. Und zwar optimiert für die Google-Suche und für diverse Formate, von Kacheln für Instagram zu Business-Posts für LinkedIn bis zu längeren Feature-Stories für Magazine. Geschmückt mir „originellen“ Zitaten der Forschenden, die ChatGPT aus einem „Best of Carl Sagan“ kombiniert. Ich arbeite dann nur noch ein paar Stunden pro Woche als „Textschubserin“ und schiebe von der KI erstellten Content in die entsprechenden Nachrichtenkanäle. Obwohl – das lässt sich auch prima automatisieren.

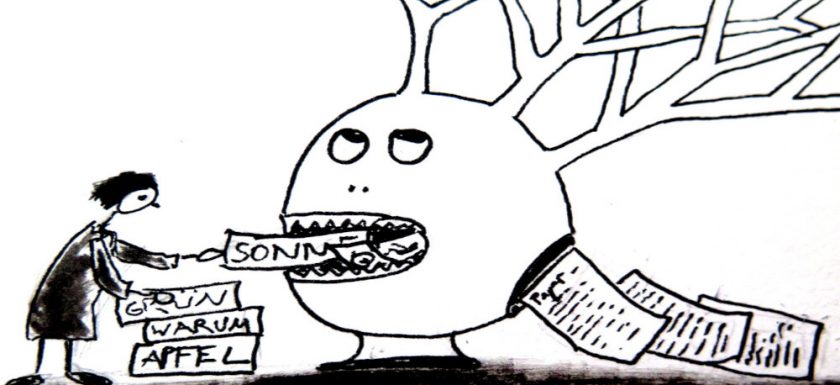

Werden wir zu „faul“, um selbst zu schreiben?

Wir können jetzt schon in natürlicher Sprache mit einem KI-System kommunizieren, das in unserem Auftrag Dokumente erstellt. Der Prozess des Schreibens vertieft jedoch das Nachdenken. Beim Lesen oder Hören bin ich oft viel zu schnell überzeugt, dass ich etwas verstanden habe. Soll ich diesen Inhalt jedoch in eigene Worte fassen, kommen neue Fragen auf. Ich möchte daher auf das schreiben, kritzeln, skizzieren, nicht verzichten. Ich suche auch gern selber nach dem besten Ausdruck für einen Sachverhalt oder eine Wahrnehmung. Vorgekaut schmeckt es mir nicht.

Aber vielleicht bin ich einfach altmodisch. Eine Veränderung der menschlichen Schriftkultur ist nicht das Ende der Zivilisation. Sokrates würde es vielleicht begrüßen, dass wir immer mehr mündlich miteinander kommunizieren. Seine Sorge damals, in der Antike: Mit dem Aufkommen der Schrift würde das Gedächtnis der jungen Generation nachlassen. Das wissen wir allerdings nur, weil sein Schüler Platon es aufgeschrieben hat. Künftig schreibt dann vielleicht ein Programm.

Lesen Sie auch den Beitrag zu ChatGPT als Assoziationsmaschine

Weitere Informationen:

Die Medienakademie der Friedrich-Ebert-Stiftung 2023 fand Mitte November in Berlin statt. Im Live-Blog können Sie einige Eindrücke nacherleben: https://www.fes.de/medienakademie-2023

Außerdem: There is an AI for That

Zur Autorin: Antonia Rötger ist Wissenschaftsredakteurin am HZB. Sie nutzt DeepL zum raschen Umschalten zwischen Englisch und Deutsch. ChatGPT findet sie nützlich, um langatmige Texte auf Bulletpoints zu reduzieren. Sie ist gespannt auf die weitere Entwicklung.